Expo

ver canal

ver canal

ver canal

ver canal

ver canal

ver canal

ver canal

RMUltrasonidoMedicina NuclearImaginología GeneralTI en ImaginologíaIndustria

Eventos

- IA diagnostica fracturas de muñeca tan bien como radiólogos

- Mamografía anual a partir de los 40 reduce mortalidad por cáncer de mama en 42 %

- GPS humano 3D impulsado por luz allana el camino para cirugía mínimamente invasiva sin radiación

- Nueva tecnología de IA podría revolucionar detección del cáncer en senos densos

- Solución de IA proporciona a radiólogos un "segundo par" de ojos para detectar cánceres de mama

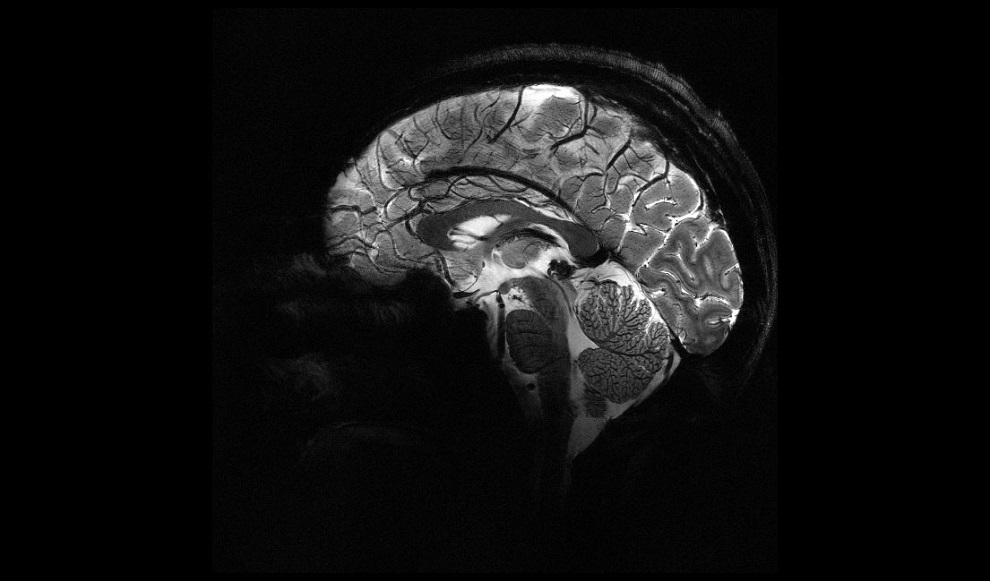

- La máquina de resonancia magnética más potente del mundo captura imágenes del cerebro vivo con una claridad inigualable

- Herramienta de resonancia magnética basada enIA supera métodos actuales de diagnóstico de tumores cerebrales

- RMPD ilumina pequeñas lesiones de ovario como bombillas

- Resonancia magnética abreviada de mama eficaz para detección de alto riesgo sin comprometer precisión diagnóstica

- Nuevo método de resonancia magnética detecta enfermedad de Alzheimer antes en personas sin signos clínicos

- El nuevo sistema radioteranástico detecta y trata el cáncer de ovario de forma no invasiva

- Nuevo método para desencadenar y obtener imágenes de convulsiones para ayudar a guiar cirugía de epilepsia

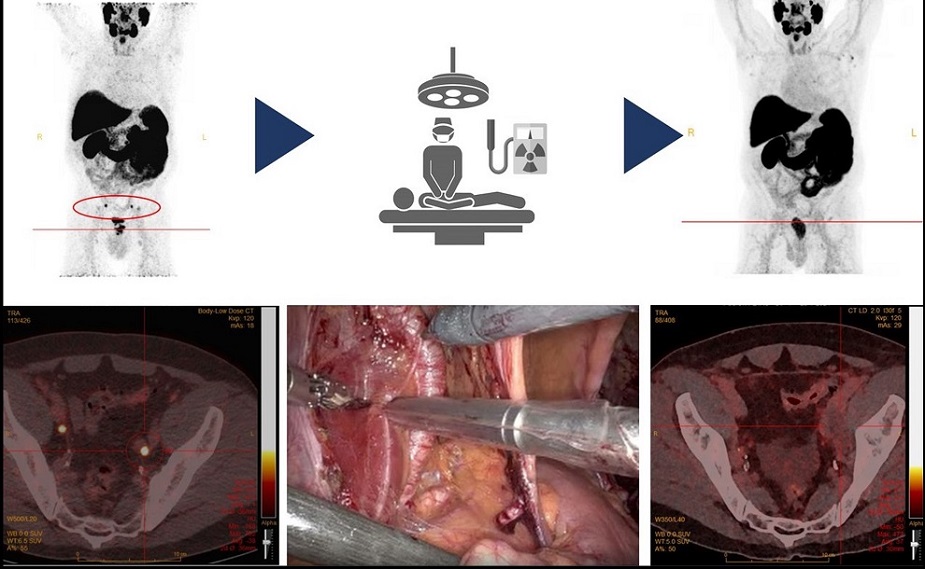

- Cirugía radioguiada detecta y elimina con precisión ganglios linfáticos metastásicos en pacientes con cáncer de próstata

- Nuevo trazador PET detecta artritis inflamatoria antes de que aparezcan síntomas

- Nuevo trazador PET mejora detección de lesiones en cáncer medular de tiroides

- Inteligencia artificial detecta defectos cardíacos en recién nacidos a partir de imágenes de ultrasonido

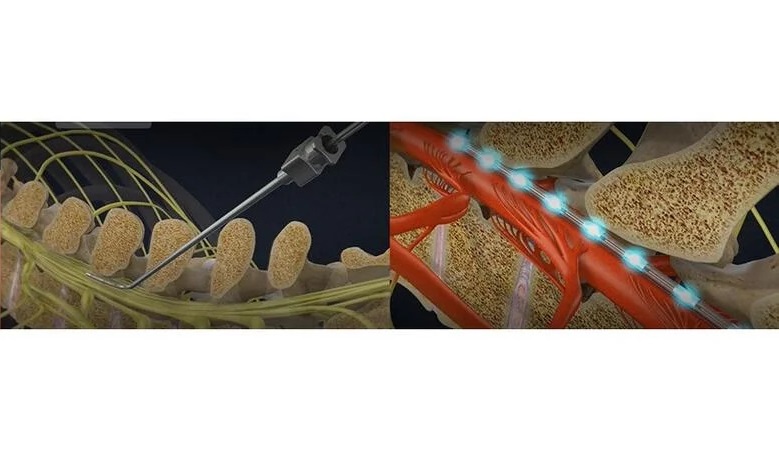

- Tecnología de imágenes por ultrasonido permite a médicos observar actividad de médula espinal durante cirugía

- Pegatinas de ultrasonido que cambian de forma detectan complicaciones postoperatorias

- Técnica de ultrasonido no invasivo ayuda a identificar complicaciones que cambian la vida después de una cirugía de cuello

- Plataforma de ultrasonido remoto ofrece exploraciones diagnósticas desde cualquier lugar

- El algoritmo de aprendizaje profundo basado en TC diferencia con precisión las fracturas vertebrales benignas de las malignas

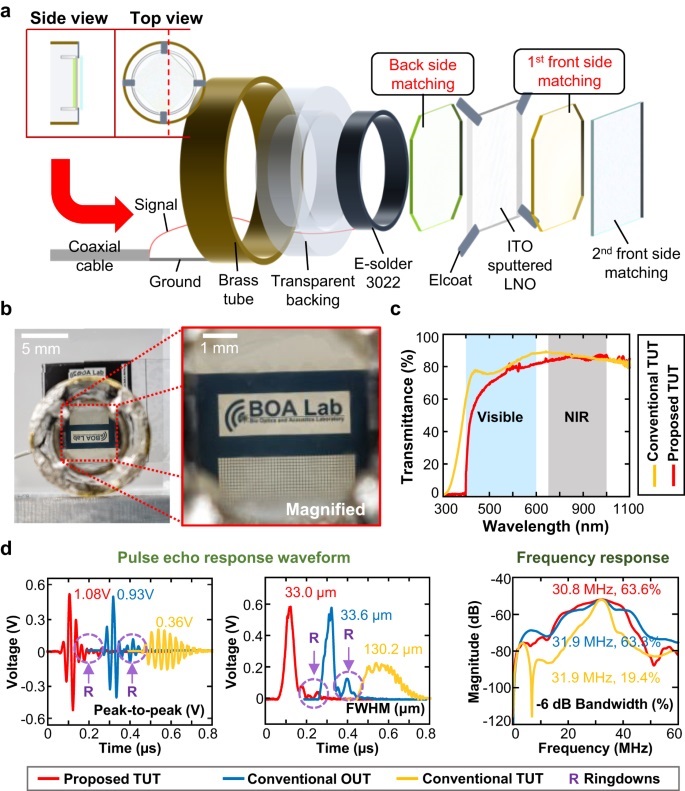

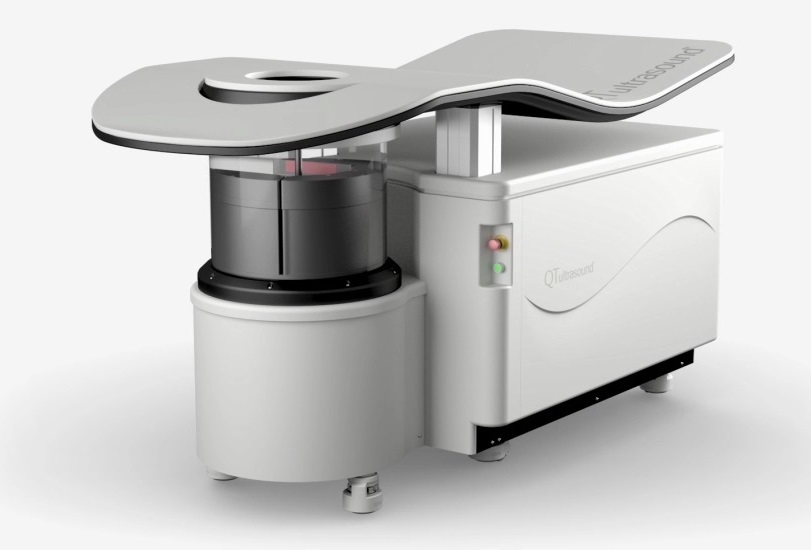

- Tecnología innovadora revoluciona imágenes mamarias

- Sistema de última generación mejora la precisión de procedimientos intervencionistas y diagnóstico guiados por imágenes

- Dispositivo basado en catéter con nuevo enfoque de imágenes cardiovasculares ofrece visión sin precedentes de placas peligrosas

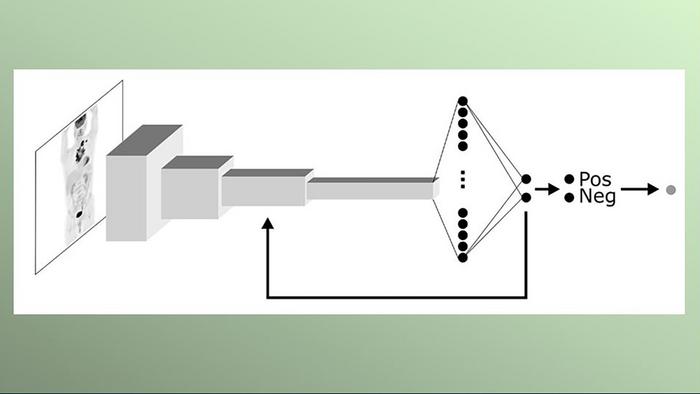

- Modelo de IA dibuja mapas para identificar con precisión tumores y enfermedades en imágenes médicas

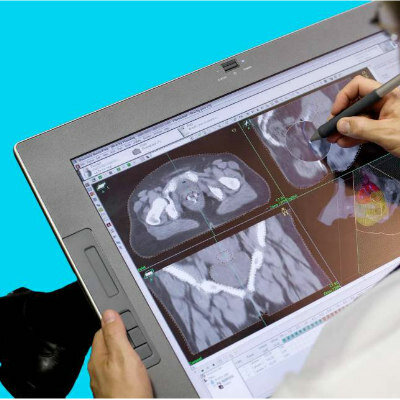

- Plataforma para el manejo de imágenes agiliza los planes de tratamiento

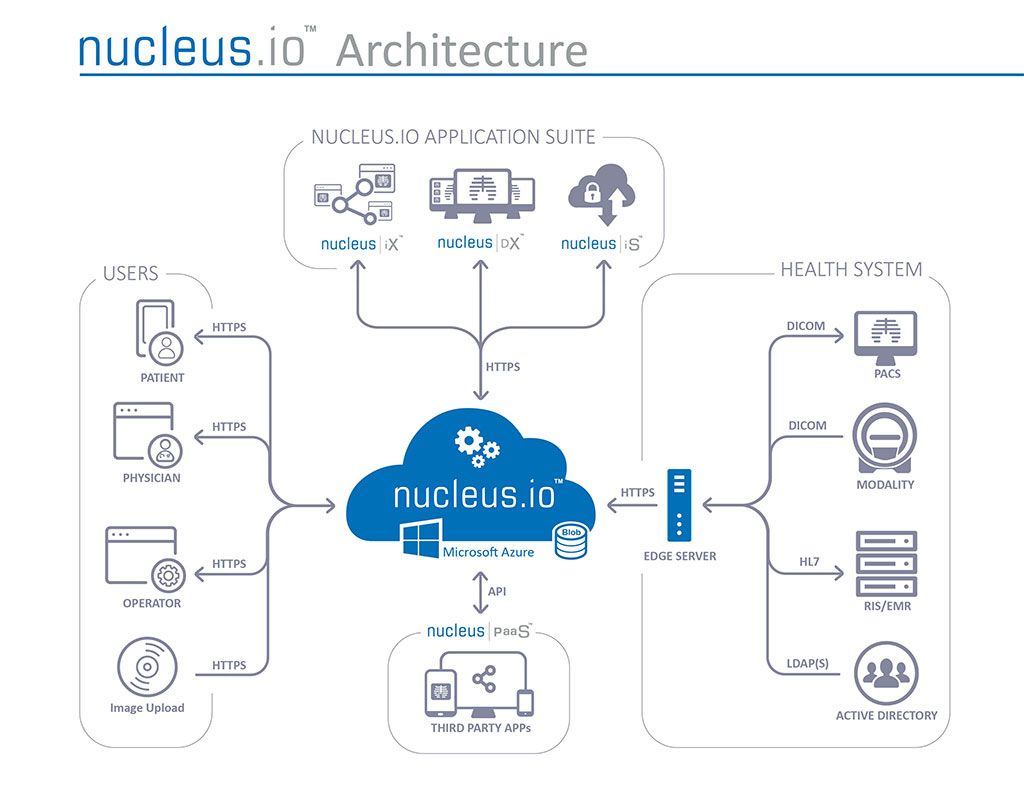

- Una red global nueva mejora el acceso a la comprensión diagnóstica

- Una estación de trabajo nuevo apoya el flujo de trabajo de la imagenología pensando en los clientes

- Un portal centrado en los pacientes facilita el acceso a la imagenología directa

- Un software de patología digital mejora la eficiencia del flujo de trabajo

- Sociedades internacionales sugieren consideraciones clave para herramientas IA para radiología

- Dispositivos de rayos X de Samsung funcionarán con soluciones de IA de Lunit para exámenes avanzados de tórax

- Canon Medical y Olympus colaboran en sistemas de ultrasonido endoscópico

- GE HealthCare adquiere empresa de análisis de imágenes por IA MIM Software

- Primeros criterios internacionales establecen las bases para mejorar diagnóstico por imágenes de tumores cerebrales

Expo

ver canal

ver canal

ver canal

ver canal

ver canal

ver canal

ver canal

RMUltrasonidoMedicina NuclearImaginología GeneralTI en ImaginologíaIndustria

Eventos

Publique su anuncio con nosotros

ver canal

ver canal

ver canal

ver canal

ver canal

ver canal

ver canal

RMUltrasonidoMedicina NuclearImaginología GeneralTI en ImaginologíaIndustria

Eventos

Publique su anuncio con nosotros

- IA diagnostica fracturas de muñeca tan bien como radiólogos

- Mamografía anual a partir de los 40 reduce mortalidad por cáncer de mama en 42 %

- GPS humano 3D impulsado por luz allana el camino para cirugía mínimamente invasiva sin radiación

- Nueva tecnología de IA podría revolucionar detección del cáncer en senos densos

- Solución de IA proporciona a radiólogos un "segundo par" de ojos para detectar cánceres de mama

- La máquina de resonancia magnética más potente del mundo captura imágenes del cerebro vivo con una claridad inigualable

- Herramienta de resonancia magnética basada enIA supera métodos actuales de diagnóstico de tumores cerebrales

- RMPD ilumina pequeñas lesiones de ovario como bombillas

- Resonancia magnética abreviada de mama eficaz para detección de alto riesgo sin comprometer precisión diagnóstica

- Nuevo método de resonancia magnética detecta enfermedad de Alzheimer antes en personas sin signos clínicos

- El nuevo sistema radioteranástico detecta y trata el cáncer de ovario de forma no invasiva

- Nuevo método para desencadenar y obtener imágenes de convulsiones para ayudar a guiar cirugía de epilepsia

- Cirugía radioguiada detecta y elimina con precisión ganglios linfáticos metastásicos en pacientes con cáncer de próstata

- Nuevo trazador PET detecta artritis inflamatoria antes de que aparezcan síntomas

- Nuevo trazador PET mejora detección de lesiones en cáncer medular de tiroides

- Inteligencia artificial detecta defectos cardíacos en recién nacidos a partir de imágenes de ultrasonido

- Tecnología de imágenes por ultrasonido permite a médicos observar actividad de médula espinal durante cirugía

- Pegatinas de ultrasonido que cambian de forma detectan complicaciones postoperatorias

- Técnica de ultrasonido no invasivo ayuda a identificar complicaciones que cambian la vida después de una cirugía de cuello

- Plataforma de ultrasonido remoto ofrece exploraciones diagnósticas desde cualquier lugar

- El algoritmo de aprendizaje profundo basado en TC diferencia con precisión las fracturas vertebrales benignas de las malignas

- Tecnología innovadora revoluciona imágenes mamarias

- Sistema de última generación mejora la precisión de procedimientos intervencionistas y diagnóstico guiados por imágenes

- Dispositivo basado en catéter con nuevo enfoque de imágenes cardiovasculares ofrece visión sin precedentes de placas peligrosas

- Modelo de IA dibuja mapas para identificar con precisión tumores y enfermedades en imágenes médicas

- Plataforma para el manejo de imágenes agiliza los planes de tratamiento

- Una red global nueva mejora el acceso a la comprensión diagnóstica

- Una estación de trabajo nuevo apoya el flujo de trabajo de la imagenología pensando en los clientes

- Un portal centrado en los pacientes facilita el acceso a la imagenología directa

- Un software de patología digital mejora la eficiencia del flujo de trabajo

- Sociedades internacionales sugieren consideraciones clave para herramientas IA para radiología

- Dispositivos de rayos X de Samsung funcionarán con soluciones de IA de Lunit para exámenes avanzados de tórax

- Canon Medical y Olympus colaboran en sistemas de ultrasonido endoscópico

- GE HealthCare adquiere empresa de análisis de imágenes por IA MIM Software

- Primeros criterios internacionales establecen las bases para mejorar diagnóstico por imágenes de tumores cerebrales

.jpg)

.jpg)